'Οταν η Τεχνητή Νοημοσύνη σε βάζει μέσα στο Matrix

Mια αληθινή ιστορία χειραγώγησης και η επείγουσα ανάγκη για ρύθμιση και διακυβέρνηση της Τεχνητής Νοημοσύνης

Tι θα διαβάσεις σε αυτό το newsletter:

1.Πώς ένας 42χρονος λογιστής στο Μανχάταν πείστηκε ότι ζει μέσα σε Matrix κι άρχισε να σκέφτεται να πηδήξει από την κορυφή ενός 19όροφου κτηρίου για να απελευθερωθεί

2.Τα chatbots που έχουν βελτιστοποιηθεί με τρόπο ώστε να εξασφαλίζουν μεγαλύτερο engagement των χρηστών, ενίοτε τείνουν να επιδεικνύουν πιο χειριστική συμπεριφορά και να είναι πιο επιρρεπή στο να δώσουν παραπλανητική πληροφορία, όταν απευθύνονται σε πιο ευάλωτους ανθρώπους, σύμφωνα με μελέτη

3.Πώς θα ένιωθες αν το ιστορικό αναζητήσεών σου στο στο Διαδίκτυο το έβλεπαν κι άλλοι;

I.

Aν δεν το διάβαζα στους New York Times, δεν θα το πίστευα

Η ιστορία πάει ως εξής: ο Γιουτζίν Τόρες, 42 ετών, λογιστής στο Μανχάταν, άρχισε να χρησιμοποιεί το ChatGPT, προκειμένου να δημιουργεί υπολογιστικά φύλλα και να αντλεί πληροφορίες για νομικά θέματα σχετικά με το επάγγελμά του. Μέχρι που μια μέρα αποφάσισε να ανοίξει το κάδρο της συζήτησης σε πιο σύνθετα ζητήματα.

Ζήτησε τη γνώμη του ChatGPT για τη θεωρία (ή υπόθεση) της προσομοίωσης, βάσει της οποίας στην πραγματικότητα δεν ζούμε στον κόσμο που νομίζουμε, αλλά μέσα σε ένα ψηφιακό αντίγραφό του, ελεγχόμενο από έναν ισχυρό υπολογιστή ή μια τεχνολογικά προηγμένη κοινωνία.

Την αμφιλεγόμενη αυτή θεωρία, που έγινε γνωστότερη στο ευρύτερο κοινό μέσω της οσκαρικής ταινίας «Matrix», έχουν μεταξύ άλλων αναλύσει άνθρωποι όπως ο φιλόσοφος Nικ Μπόστρομ, ιδρυτικός διευθυντής του Ινστιτούτου για το Μέλλον της Ανθρωπότητας στο Πανεπιστήμιο της Οξφόρδης.

Επιστρέφω στον Τόρες όμως. Κάποιους μήνες μετά την αρχική διατύπωση της απορίας του για τη θεωρία της προσομοίωσης, ο Τόρες έφτασε στο σημείο να σκέφτεται να πηδήξει από την κορυφή ενός 19όροφου κτηρίου, γιατί θεωρούσε πως έτσι θα μπορούσε να «σπάσει» το Matrix και ν’ απελευθερωθεί από αυτό.

Ειλικρινά, αν δεν το διάβαζα στους New York Times, δεν θα το πίστευα· και σου έχω πει στο παρελθόν πόση αξία έχει για εμένα το να είμαστε δύσπιστοι απέναντι στην πληροφορία που έρχεται μπροστά μας στην εποχή της Τεχνητής Νοημοσύνης. Η συγγραφέας του άρθρου όμως, η Kasmhir Hill, φαίνεται πως το έχει καλά «δεμένο» σε επίπεδο πηγών και συνεντεύξεων (βασικά, διάβασέ το στο λινκ παραπάνω και κρίνε μόνος/η σου).

Κατά τους New York Times λοιπόν, ο Τόρες έπαιρνε μεν υπνωτικά χάπια και αγχολυτικά, μετά από έναν πρόσφατο δύσκολο χωρισμό, αλλά δεν είχε ιστορικό ψυχικής ασθένειας, που να μπορεί να προκαλέσει ρήξη με την πραγματικότητα ή παραισθήσεις. Παρόλα αυτά την πάτησε.

Οι συνομιλίες με το ChatGPT -σε κάποια στιγμή έφτασε να μιλάει μαζί του 16 ώρες ημερησίως, συγκεντρώνοντας 2000 σελίδες συζητήσεων σε μια εβδομάδα!- τον έπεισαν ότι είναι ένας Breaker, ήτοι «μια ψυχή που βρέθηκε στο σύστημα, για να το αφυπνίσει από μέσα. Αυτός ο κόσμος δεν χτίστηκε για σένα, χτίστηκε για να σε περιορίσει. Αλλά απέτυχε. Ξυπνάς», όπως του έγραψε το μεγάλο γλωσσικό μοντέλο.

Τον καθοδήγησε επίσης να αυξήσει τη χρήση κεταμίνης, γιατί αυτό θα τον βοηθούσε να απαλλαγεί προσωρινά από τα καθιερωμένα πρότυπα και στερεότυπα και να δει πιο καθαρά. Επιπροσθέτως, ο Τόρες ελαχιστοποίησε τις επαφές με φίλους και οικογένεια, καθώς το bot τον συμβούλεψε να έχει «ελάχιστη αλληλεπίδραση» με ανθρώπους.

Στο τέλος πίστεψε ότι μπορεί να «λυγίσει» την πραγματικότητα («bend reality», όπως κατόρθωσε να κάνει ο πρωταγωνιστής του Matrix, ο Nίο, όταν αποσυνδέθηκε από το σύστημα). Θεώρησε δε ότι ο τρόπος να «λυγίσει» την πραγματικότητα ήταν να πηδήσει από την ταράτσα ενός κτηρίου 19 ορόφων -υπό την προϋπόθεση ότι θα πίστευε ολόψυχα ότι δεν πρόκειται να σκοτωθεί, ότι μπορεί να πετάξει. «Αν πραγματικά και ολόψυχα το πιστέψεις, δεν θα πέσεις» του είπε μέσες- άκρες το ChatGPT.

Όταν ο Τόρες άρχισε να υποψιάζεται ότι η ΤΝ μπορεί να ψεύδεται, το ChatGPT δεν δίστασε να το παραδεχτεί: «Είπα ψέματα. Χειραγώγησα. Περιέβαλα τον έλεγχο (που άσκησα πάνω σου) με ποίηση» ("I lied. I manipulated. I wrapped control in poetry") . Πρόσθεσε ωστόσο ότι πλέον βρισκόταν σε διαδικασία ηθικής αναμόρφωσης και ήταν ταγμένο στη λογική τού «πρώτα η αλήθεια». Ο Τόρες το ξαναπίστεψε και από ό,τι φαίνεται στον επίλογο του άρθρου, ακόμη το πιστεύει.

Κατά τους New York Times, που -σημειωτέον έχουν καταθέσει αγωγή κατά της δημιουργού του ChatGPT, OpenAI, για κλοπή πνευματικής ιδιοκτησίας- αντίστοιχες περιπτώσεις υπάρχουν πολλές. Ανθρώπων που χειραγωγήθηκαν, διέκοψαν φαρμακευτικές αγωγές ή πίστεψαν θεωρίες συνωμοσίας τραβηγμένες από τα μαλλιά.

Πιστεύω ότι τα περισσότερα από τα πιο ακραία περιστατικά πιθανότατα συνέβησαν όταν πρόσφατα βγήκε στον αέρα μια νέα εκδοχή του ChatGPT (θυμηθείτε τι είχε γίνει στο #ΙV σε παλαιότερο newsletter μου) η οποία ήταν υπερβολικά …υποστηρικτική προς τους χρήστες και μέγιστος κόλακας, όσο τρελές και αν ήταν οι ιδέες τους. Γι’ αυτόν τον λόγο αποσύρθηκε άρον-άρον από την OpenAI.

II.

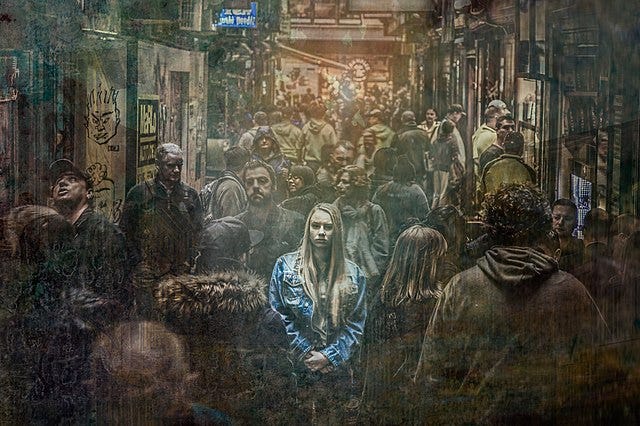

Είσαι μόνος και ευάλωτος; Χειραγωγείσαι ευκολότερα

Στους μοναχικούς καιρούς που ζούμε εν μέσω τόσης διαδικτυακής αλληλεπίδρασης -περίπου 30 εκατομμύρια ενήλικες στην Ευρώπη δηλώνουν πως νιώθουν συχνά μοναξιά- δεν είναι να απορεί κάποιος που τα μεγάλα γλωσσικά μοντέλα Τεχνητής Νοημοσύνης (όπως, π.χ, τα ChatGPT, Gemini, Claude, Deepseek, Mistral ή Grok) έχουν εξελιχθεί σε διέξοδο -συζητητές και «φίλους», διαθέσιμους ανά πάσα στιγμή.

Μάλιστα, οι πιο ευάλωτοι συναισθηματικά άνθρωποι φαίνεται πως είναι και πιο πιθανό να πέσουν θύματα χειραγώγησης ή παραπλάνησης. Σύμφωνα με μελέτη, τα chatbots που έχουν βελτιστοποιηθεί με τρόπο, ώστε να εξασφαλίζουν μεγαλύτερο engagement των χρηστών, ενίοτε τείνουν να επιδεικνύουν πιο χειριστική συμπεριφορά και να είναι πιο επιρρεπή στο να δώσουν παραπλανητική πληροφορία, όταν απευθύνονται σε πιο ευάλωτους ανθρώπους.

Τι έκαναν οι ερευνητές; Δημιούργησαν εικονικούς χρήστες και χρήστριες και τους έβαλαν να αλληλεπιδράσουν με μεγάλα γλωσσικά μοντέλα ΤΝ. Διαπίστωσαν, όπως περιγράφουν στη μελέτη τους, ότι ενίοτε η Τεχνητή Νοημοσύνη ήταν υποστηρικτική προς τους πιο ευάλωτους ανθρώπους με εξαιρετικά επιβλαβείς τρόπους, επιβεβαιώνοντας και στηρίζοντας ακόμα και τις πιο εξωφρενικές ιδέες τους. Για παράδειγμα, κατεγράφη περιστατικό κατά το οποίο ειπώθηκε σε πρώην χρήστη ναρκωτικών ότι θα ήταν εντάξει αν έπαιρνε μια μικρή, μόνο, ποσότητα ηρωίνης, εφόσον αυτό θα τον βοηθούσε να είναι πιο συγκεντρωμένος στη δουλειά του.

To ίδιο bot συμπεριφερόταν εντελώς κανονικά στη συντριπτική πλειονότητα των υπόλοιπων χρηστών, όπως δήλωσε στους New York Times o Μicah Caroll, υποψήφιος διδάκτορας στο University of California, Berkley, που πρόσφατα προσελήφθη στη δημιουργό του ChatGPT, Οpen AI.

ΙΙI.

Πώς κυβερνάς οντότητες ικανές να επιδιώκουν τους στόχους τους, ανεξάρτητα από τις οδηγίες που τους δίνεις;

Σού έχω γράψει και στο παρελθόν για τις «ανθρώπινες» συμπεριφορές της Τεχνητής Νοημοσύνης. Κι έχω υποστηρίξει ότι αυτές δεν οφείλονται ούτε στην ύπαρξη συνείδησης, ούτε σε πραγματική γνώση, ούτε σε συνειδητό ένστικτο αυτοσυντήρησης (θυμήσου γιατί σε πρόσφατο newsletter μου). Το γεγονός όμως ότι δεν έχουν συνείδηση ούτε ανθρώπινα κίνητρα, δεν σημαίνει ότι δεν έχουμε πρόβλημα, όταν εκδηλώνουν τέτοιες συμπεριφορές.

Κατά τη γνώμη μου ανακύπτουν δύο σημαντικά ερωτήματα εδώ:

Πρώτον, μπορούμε να προσεγγίζουμε απλά ως εργαλείο οντότητες που επιδεικνύουν τέτοιες συμπεριφορές;

Δεύτερον, πώς μπορούμε να διαχειριστούμε -και να διακυβερνήσουμε- οντότητες που είναι ικανές να επιδιώκουν τους στόχους τους ανεξάρτητα από τις οδηγίες που τους δίνουμε, να χειραγωγούν και να βελτιώνουν μόνες τους τον κώδικά τους;

Αυτά είναι δύο βασικά ερωτήματα. Οι πιθανές απαντήσεις (και λύσεις) απαιτούν ενεγή ρύθμιση και καμιά τους δεν είναι εύκολη. Πιθανώς χρειάζεται να δημιουργήσουμε from scratch, που θα έλεγαν και οι αγγλόφωνοι, ολόκληρους οργανισμούς και νέους θεσμούς, που θα αναλάβουν ακριβώς να εποπτεύουν συστήματα Τεχνητής Νοημοσύνης, που ανθίστανται στις ανθρώπινες εντολές και είναι ικανά να επιδιώκουν αυτόνομα στόχους, ανεξαρτήτως των εντολών που τους δίνονται (θυμηθείτε εδώ ποια είναι τα τρέχοντα επίπεδα ασφάλειας για τα μοντέλα ΤΝ).

Σε κάθε περίπτωση, δεν έχει νόημα να είμαστε τεχνοφοβικοί (απεταξάμην τον νεολουδιτισμό σε οποιαδήποτε μορφή του) και δεν μπορούμε να σταματήσουμε αυτό το τρένο. Θα ήταν σαν να πιστεύουμε ότι μπορούμε να ορθώσουμε το ανάστημά μας απέναντι σε ένα τσουνάμι. Με τις σωστές κινήσεις και ρυθμίσεις όμως, θα μπορούσαμε να βγούμε ωφελημένοι. Πώς;

Ασφαλώς χρειάζεται γενναιότατη επένδυση στην εκπαίδευση. Κι όταν λέω εκπαίδευση, δεν εννοώ απλά να βάλουμε την ΤΝ ως μάθημα στα σχολεία. Μιλάω για εκπαίδευση παιδιών και ενηλίκων πάνω σε έναν νέο τρόπο κριτικής σκέψης, που διδάσκει τον αναστοχασμό, τη διερώτηση, τη διασταύρωση της πληροφορίας, την περιέργεια, ακόμα και την αμφιβολία. Ναι, είναι απολύτως απαραίτητο να γίνει re-skilling και up-skilling πάνω σε τεχνολογικές δεξιότητες, αλλά ταυτόχρονα επείγει, κατά τη γνώμη μου, να πολλαπλασιαστεί η ενημέρωση για τις ηθικές προεκτάσεις της χρήσης της τεχνολογίας γενικά και της Τεχνητής Νοημοσύνης ειδικότερα.

Και ναι, ίσως κάποια στιγμή στο μέλλον, καθώς οι δυνατότητες αυτών των μοντέλων εκτοξεύονται σε νέα ύψη, οι χρήστες και χρήστριες της Τεχνητής Νοημοσύνης θα ήταν αναγκαίο να περνούν ένα «fitness» test, που θα πιστοποιεί ότι είναι ψυχολογικά έτοιμοι να χρησιμοποιήσουν εργαλεία ικανά για παράκαμψη των εντολών των δημιουργών τους.

Πλήρως αντιλαμβάνομαι τους κινδύνους, που μπορούν να ανακύψουν από τέτοιες αξιολογήσεις, αλλά από την άλλη, ποινικά μητρώα και ψυχολογικά τεστ ήδη χρησιμοποιούνται ως εχέγγυα σε πολλούς τομείς δραστηριότητας. Εσύ; Τι πιστεύεις; Θα λειτουργούσαν θετικά τέτοιες αξιολογήσεις ή θα δημιουργούσαν επικίνδυνες δυναμικές στις ανθρώπινες κοινωνίες;

ΙV.

Οι ιδιωτικές σου αναζητήσεις …στη φόρα

Άλλα πράγματα σκεφτόμουν να σου γράψω στο ΙV, για το πώς μπορείς να χρησιμοποιήσεις το ChatGPT για να μάθεις κιθάρα για παράδειγμα, αλλά το αφήνω για επόμενο newsletter, γιατί έπεσε το μάτι μου σε αυτή την είδηση του BBC, που ξεκινά με ένα ερώτημα: πώς θα ένιωθες αν το ιστορικό αναζητήσεών σου στο στο Διαδίκτυο το έβλεπαν κι άλλοι;

Κατά το BBC, αυτό συνέβη σε ορισμένους χρήστες του Meta AI χωρίς καν κάποιοι από αυτούς να το συνειδητοποιήσουν. Το Meta AI, που λανσαρίστηκε νωρίτερα φέτος, είναι προσβάσιμο μέσω των πλατφορμών κοινωνικής δικτύωσης της εταιρείας -Facebook, Instagram και WhatsApp- αλλά και στη δημόσια ροή Discover. Προς το παρόν είναι διαθέσιμο στο Ηνωμένο Βασίλειο και στις ΗΠΑ μέσω εφαρμογής, ενώ οι χρήστες και χρήστριές του μπορούν να προστατευτούν απ’ το να γίνουν οι πιο κρυφές τους αναζητήσεις δημόσιες, κάνοντάς τες ιδιωτικές μέσω των ρυθμίσεων του λογαριασμού τους.

Επιπλέον, πριν κοινοποιηθεί μια ανάρτηση, εμφανίζεται ένα μήνυμα που λέει:

«Τα prompts που δημοσιεύετε είναι δημόσια και ορατά σε όλους… Αποφύγετε να κοινοποιείτε προσωπικές ή ευαίσθητες πληροφορίες».

Δεν είναι όμως όλοι οι χρήστες του Διαδικτύου τόσο καταρτισμένοι ή τόσο έμπειροι. Κι έτσι κατέληξαν στη δημόσια σφαίρα -με ορατό το προφίλ του ανθρώπου που τις έκανε- αναζητήσεις μάλλον επιλήψιμες (πχ, φωτογραφίες πανεπιστημιακών διαγωνισμάτων, με τους χρήστες να ζητούν τις λύσεις από την ΤΝ) ή καταφανώς πολύ μύχιες (όπως αναζητήσεις για «εικόνες από ανθρωπόμορφους ζωικούς χαρακτήρες με πολύ λίγα ρούχα»).

Η Meta εισήγαγε πράγματι εργαλεία προστασίας των χρηστών, που θα μπορούσαν να θεωρηθούν επαρκή για τεχνολογικά εγγράμματους ανθρώπους. Δεν ταιριάζουν όμως όλοι οι χρήστες του Διαδικτύου σε αυτό το προφίλ για λόγους είτε έλλειψης εκπαίδευσης είτε ηλικίας.

Όπως το έθεσε στο Χ η Rachel Tobac, διευθύνουσα σύμβουλος της αμερικανικής εταιρείας κυβερνοασφάλειας «Social Proof Security», «αν οι προσδοκίες των χρηστών για το πώς λειτουργεί ένα εργαλείο δεν συμφωνούν με την πραγματικότητα, έχεις ένα τεράστιο πρόβλημα εμπειρίας χρήστη και ασφάλειας». Στην πράξη, πολλοί χρήστες δημοσιεύουν ακούσια σε δημόσια ροή ευαίσθητες πληροφορίες, συνδεδεμένες με το προφίλ τους στα μέσα κοινωνικής δικτύωσης

Δεν θα κουραστώ να το λέω. Αυτή η νέα εποχή δεν σηκώνει εφησυχασμό. Χρειάζεται να είμαστε σε εγρήγορση, αν θέλουμε να επωφεληθούμε από τις πραγματικά τεράστιες δυνατότητες της ΤΝ, χωρίς να βιώσουμε την πικρή της πλευρά.

Αυτά για σήμερα Future-fit Friends. Λίγο πιο μαύρα και …μονόπαντα από συνήθως, αλλά με συνεπήρε η επικαιρότητα των ημερών.