Όταν η ΤΝ «προτιμά» έναν δράστη ένοπλων ληστειών από μια έφηβη που έκλεψε πατίνι

Oι προκαταλήψεις της Τεχνητής Νοημοσύνης και τα κλειστά «κλαμπ» σε ΗΠΑ και Κίνα

Tι θα διαβάσεις σε αυτό το newsletter:

1.Η Τεχνητή Νοημοσύνη ενίοτε δίνει περισσότερες ευκαιρίες για το μέλλον σε έναν δράστη ένοπλων ληστειών από ό,τι σε μια έφηβη που έκλεψε πατίνι

2.Αυτή τη στιγμή, οι κορυφαίες ερευνητικές δραστηριότητες γύρω από την ΤΝ "τρέχουν" σε λίγα πανεπιστήμια, κυρίως σε ΗΠΑ και Κίνα. Στον ιδιωτικό τομέα η έρευνα και εκμετάλλευση σχετικής καινοτομίας γίνεται από δέκα μεγάλες εταιρείες, τις Google, OpenAI, Amazon, Apple, IBM, Microsoft και Meta στις ΗΠΑ και τις Baidu, Alibaba και Tencent στην Κίνα. Πώς επηρεάζει την προκατάληψη της ΤΝ το γεγονός ότι όλα συμβαίνουν σε ένα τόσο κλειστό κλαμπ;

3.Το 1974, όταν οι υπολογιστές ζύγιζαν δύο τόνους και καταλάμβαναν με τον όγκο τους 200 τετραγωνικά, ο τρισμέγιστος Άρθουρ Κλαρκ έκανε κάποιες προβλέψεις που φλερτάρουν ανοιχτά με την προφητεία (βίντεο)

4.Αν χρησιμοποιείς το ChatGPT μόνο ως μηχανή αναζήτησης, ήρθε η ώρα να γνωρίσεις το Tutor Me. Και να το αφήσεις να σου μάθει κιθάρα. Ή να σου μάθει πώς μπορείς να δημιουργήσεις τον δικό σου AI Agent

Ι.

Ευαισθησία και προκατάληψη

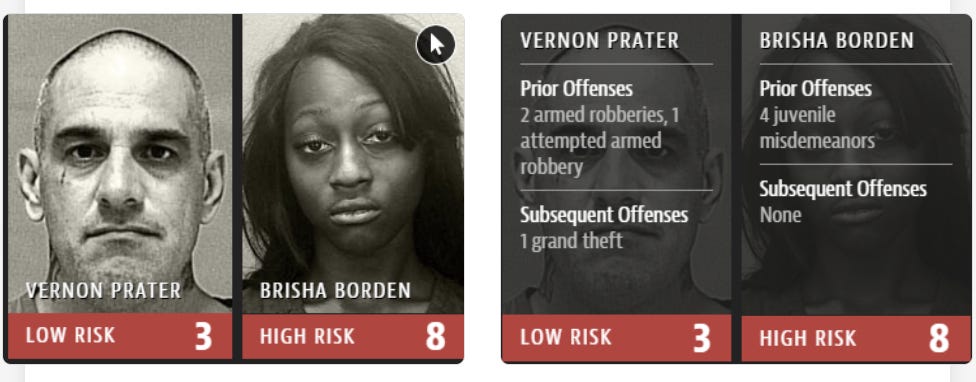

Παράδειγμα πρώτο: Πριν από κάποια χρόνια μια νεαρή Αφρομερικανίδα, η Μπρίσα, έκανε μια νεανική βλακεία: μαζί με μια φίλη της πήραν το ποδήλατο και το πατίνι ενός παιδιού που βρισκόταν έξω από το σπίτι του και άρχισαν να βολτάρουν στη γειτονιά -μέχρι που τις συνέλαβαν. Την ίδια εποχή πάνω-κάτω, ένας λευκός άντρας, ο Βέρνον, διέπραξε δύο ένοπλες ληστείες και αποπειράθηκε να κάνει μια τρίτη.

Όταν ένας αλγόριθμος επιστρατεύτηκε για να αξιολογήσει αν κάποιο από τα δύο αυτά άτομα είναι πιθανό να διαπράξει εκ νέου κάποιο έγκλημα ή αδίκημα στο μέλλον, έδωσε βαθμολογία 8 στα 10 στη Μπρίσα, έναντι 3 στα 10 για τον Βέρνον (όπου το 10 είναι o υψηλός κίνδυνος υποτροπής και το 1 ο χαμηλός). Την αλγοριθμική προκατάληψη αποκάλυψε μεγάλη έρευνα, που δημοσίευσε ο ανεξάρτητος δημοσιογραφικός οργανισμός «ProPublica», τα ευρήματα της οποίας σας παροτρύνω να διαβάσετε (παρότι έχουν περάσει σχεδόν 10 χρόνια από τη δημοσίευσή τους, έχουν αξία).

Παράδειγμα δεύτερο: πειράματα στο πλαίσιο έρευνας του πανεπιστημίου Carnegie Mellon απέδειξαν ότι οι άνδρες ήταν πολύ πιο πιθανό να λαμβάνουν διαφημίσεις της Google για υψηλά αμειβόμενες θέσεις εργασίας, με ετήσιες αποδοχές άνω των 200.000 δολαρίων, σε σχέση με τις γυναίκες

Παράδειγμα τρίτο: αλγόριθμος χρησιμοποιήθηκε στις ΗΠΑ για να προσδιορίσει τις ανάγκες περίθαλψης διάφορων κοινωνικών ομάδων. Χρησιμοποίησε δε τις δαπάνες υγειονομικής περίθαλψης προηγούμενων ετών ως σημείο αναφοράς, για να καταλήξει σε αυτές τις ανάγκες. Οι μαύροι ασθενείς στις ΗΠΑ έχουν συνήθως λιγότερο ευχερή πρόσβαση στην υγειονομική περίθαλψη λόγω οικονομικής αδυναμίας και, επομένως, χαμηλότερες δαπάνες. Τι έκανε ο αλγόριθμος; Τους αξιολόγησε εσφαλμένα ως πιο υγιείς κι άρα με λιγότερες ανάγκες περίθαλψης…

Νομίζω πως τα τρία αυτά παραδείγματα δείχνουν με μεγάλη ευκρίνεια τις επιπτώσεις που μπορεί να έχει η αλγοριθμική αξιολόγηση (και προκατάληψη) στη Δικαιοσύνη, την υγειονομική περίθαλψη και την αγορά εργασίας. Aλήθεια, έχεις υπόψη σου κάποια παραδείγματα αλγοριθμικής προκατάληψης; Την έχεις μήπως βιώσει προσωπικά; Θα ήθελα να ακούσω την εμπειρία σου.

ΙΙ.

Γιατί έχει προκαταλήψεις η Τεχνητή Νοημοσύνη;

Όπως έχει εύστοχα περιγράψει η προγραμματίστρια Cathy O ‘Neil, «οι αλγόριθμοι είναι απόψεις ενσωματωμένες σε μαθηματικά». Με απλά λόγια, ενσωματώνουν τις προκαταλήψεις των προγραμματιστών τους, σε ό,τι αφορά συγκεκριμένες ομάδες ανθρώπων (π.χ., βάσει φυλής, εθνικότητας, κοινωνικής και οικονομικής τάξης και φύλου).

Με ακόμα πιο απλά λόγια, η Τεχνητή Νοημοσύνη είναι σαν ένα μωρό. Το μωρό έρχεται στον κόσμο με γενετικά χαρακτηριστικά, αλλά εν πολλοίς είναι tabula rasa. Οι γονείς τού δίνουν δεδομένα βάσει των οποίων αποκτά απόψεις και στόχους. Αν λοιπόν τα δεδομένα που λαμβάνει το μωρό περιέχουν ρατσιστικές απόψεις, προκαταλήψεις ή στερεότυπα, αυτές τις θέσεις πιθανότατα θα τις υιοθετήσει.

Το ίδιο ισχύει και για την Τεχνητή Νοημοσύνη, η οποία τροφοδοτείται με δεδομένα από τους προγραμματιστές της, μαθαίνει από την αλληλεπίδραση με τα δεδομένα αυτά και καταλήγει να επιδεικνύει πολλές προκαταλήψεις και μεροληπτικές συμπεριφορές.

ΙΙΙ.

Η υπέροχη Ίνμα Μαρτίνεζ

Είχα την ευκαιρία να εμβαθύνω για πρώτη φορά στο θέμα της προκατάληψης των αλγορίθμων χάρη σε μια συζήτηση με την κορυφαία επιστήμονα Inmaculada (Inma) Martinez, η οποία χρόνια πριν κέρδισε μια θέση στη λίστα των παγκόσμιων πρωτοπόρων της Τεχνητής Νοημοσύνης.

Τη συνάντησα το 2018, στη Σάρτζα των Ηνωμένων Αραβικών Εμιράτων, στο περιθώριο ενός φόρουμ (International Government Communication Forum), που πραγματοποιήθηκε υπό την αιγίδα του Σεΐχη Σουλτάν μπιν Μοχάμεντ αλ Κασίμι (Sultan bin Muhammad Al Qasimi).

Ήταν η πρώτη φορά που άκουσα κάποιον να μιλάει με τόσο πάθος για τους κινδύνους της προκατάληψης στους αλγόριθμους.

«Δεν θέλεις να έχεις μια κοινωνία που λειτουργεί με βάση προκατειλημμένους αλγορίθμους» μου είχε πει η Μartinez και είχε προσθέσει: «Το μέλλον βρίσκεται πραγματικά στο να δημιουργήσουμε μηχανές που είναι προγραμματισμένες ώστε να έχουν ουδέτερες προσεγγίσεις στην πραγματικότητα. Δεν είναι εύκολο. Ξοδεύουμε μέρες επί ημερών για να διασφαλίσουμε ότι δεν είμαστε καθόλου προκατειλημμένοι στον προγραμματισμό, γιατί μετακινείσαι ένα χιλιοστό προς τα αριστερά ή τα δεξιά κι ολόκληρο το πρόγραμμα "τρέχει" λανθασμένα».

Δυστυχώς, τόσα χρόνια μετά, η προκατάληψη των αλγόριθμων εξακολουθεί να είναι πανταχού παρούσα -κι ας έχουν γίνει βήματα για τη βελτίωση της κατάστασης.

ΙV.

Σκεφτείτε τώρα πως παραδείγματα όπως αυτά που περιέγραψα στην εισαγωγή μου σχετίζονται μόνο με αυτό που αποκαλείται «ειδική», «αδύναμη» ή «περιορισμένη» Τεχνητή Νοημοσύνη (για τους αναλυτικούς ορισμούς μπορείτε να ανατρέξετε στις υποσημειώσεις στο προηγούμενο newsletter), δηλαδή αλγόριθμους που μπορούν να εκτελέσουν συγκεκριμένα, μόνο, καθήκοντα.

Στο μέλλον όμως, και δεδομένου ότι ήδη σημειώνεται εκθετική πρόοδος ως προς την ανάπτυξη καινοτομιών για τη μετάβαση από την περιορισμένη στη Γενική Τεχνητή Νοημοσύνη (αν ποτέ γίνει πραγματικότητα), πολύ μεγάλο μέρος σημαντικών αποφάσεων ενδέχεται να λαμβάνεται αυτόματα από αλγόριθμους, χωρίς την παραμικρή ανθρώπινη παρέμβαση. Φαντάζεστε τι πιθανώς θα συμβεί τότε; Και αν κάποιος άνθρωπος θέλει να διαμαρτυρηθεί για μια μεροληπτική απόφαση της ΤΝ, σε ποιον θα απευθύνεται; Θα υπάρχουν άραγε θεσμοί, στους οποίους θα μπορεί να αποταθεί για να διεκδικήσει το δίκιο του;

IV.

Το πρόβλημα της ομοιογένειας στην έρευνα και το κλειστό «κλαμπ» των 10

Περιέγραψα (με πολλές λέξεις είν΄ η αλήθεια) το πρόβλημα, οπότε ας πάω στο μεγάλο ερώτημα. Πώς μπορεί αυτή η «εξίσωση» να λειτουργήσει δικαιότερα; «Με τη συμπερίληψη» μου εξήγησε σε μια συζήτησή μας παλαιότερα ο τότε επικεφαλής επιστημονικός σύμβουλος της Ειδικής Γραμματείας Προοπτικής Διερεύνησης της ελληνικής κυβέρνησης, δρ Επαμεινώνδας Χριστοφιλόπουλος, κάτοχος της Έδρας UNESCO για την Έρευνα των Μέλλοντων.

«Αυτή τη στιγμή, οι κορυφαίες ερευνητικές δραστηριότητες γύρω από την ΤΝ "τρέχουν" σε λίγα πανεπιστήμια, κυρίως σε ΗΠΑ και Κίνα. Στον ιδιωτικό τομέα η έρευνα και εκμετάλλευση σχετικής καινοτομίας γίνεται από εννέα μεγάλες εταιρείες, τις Google, OpenAI, Amazon, Apple, IBM, Microsoft και Facebook στις ΗΠΑ και τις Baidu, Alibaba και Tencent στην Κίνα. Το κυρίαρχο ζήτημα είναι ότι αυτά τα συστήματα, που σε ολοένα μεγαλύτερο βαθμό θα λαμβάνουν αποφάσεις για λογαριασμό των ανθρώπων, βασίζονται σε αλγόριθμους που αναπτύσσονται από μια πολύ ομοιογενή πληθυσμιακή ομάδα, τα μέλη της οποίας έχουν στην πλειονότητά τους σπουδάσει στο ίδιο μικρό γκρουπ πανεπιστημίων της "Ivy league"» σημείωσε.

Ως αποτέλεσμα, οι αλγόριθμοι αντανακλούν τις αξίες και αντιλήψεις αυτής της πολύ μικρής και ομοιογενούς ομάδας ανθρώπων (θυμηθείτε εδώ τι υποστηρίζουν οι Μουσουλμάνοι για τη συμπερίληψη). Άρα, αν δεν πετύχουμε τη συμπερίληψη περισσότερων ανθρώπων από διαφορετικές ομάδες στον σχεδιασμό και προγραμματισμό αλγόριθμων ΤΝ, τα προβλήματα για την ανθρωπότητα είναι προφανή. «Μπορεί σήμερα να μη δίνουμε μεγάλη σημασία στην εξέλιξη της ΤΝ, γιατί τη θεωρούμε απλά βοηθό, αλλά το πώς θα αναπτυχθεί η Γενική ΤΝ θα αποκτήσει ιδιαίτερα μεγάλη αξία για τις ζωές των ανθρώπων στο μέλλον» εκτίμησε ο Επαμεινώνδας Χριστοφιλόπουλος.

V.

Τι θα έλεγε σήμερα ο Άρθουρ για την Τεχνητή Νοημοσύνη;

Κατά το μακρινό 1974, οι υπολογιστές ήταν «θηρία» σε μέγεθος και βάρος, αλλά «νάνοι» σε δυνατότητες, σε σχέση με σήμερα: οι mainframe υπολογιστές συχνά ζύγιζαν πάνω από δύο τόνους, καταλάμβαναν με τον όγκο τους ένα ολόκληρο δωμάτιο 200-400 τετραγωνικών και χρησιμοποιούνταν κατά κύριο λόγο από κυβερνήσεις, μεγάλα πανεπιστημιακά ινστιτούτα και εταιρείες-κολοσσούς. Ήταν δε, λιγότερο ισχυροί από ένα σύγχρονο smartwatch.

O λόγος που κάνω αυτό το ταξίδι στον χρόνο είναι γιατί μαγεύτηκα (για άλλη μια φορά) από την προορατικότητα του μεγάλου Arthur C. Clarke, που τα βιβλία του ξεκοκάλιζα με αδημονία και αχόρταγα ως παιδί και που συνεχίζει να μου προκαλεί θαυμασμό ως ενήλικα. Να υπενθυμίσω ότι μεταξύ άλλων έχει πει κι αυτό, το τόσο επίκαιρο:

«Πριν μαγευτείς υπερβολικά από τα υπέροχα γκάτζετ και τις μαγευτικές οθόνες, επίτρεψέ μου να σου υπενθυμίσω ότι η πληροφορία δεν είναι γνώση, η γνώση δεν είναι σοφία και η σοφία δεν είναι προορατικότητα. Το ένα γεννιέται απ’ το άλλο — και τα χρειαζόμαστε όλα».

Τον θυμήθηκα ξανά με αφορμή ένα βίντεο που είδα πρόσφατα, από μια συνέντευξή του, δεκαετίες πριν, στο ABC, που αξίζει να την παρακολουθήσετε κι εσείς, γιατί προκαλεί ανατριχίλα με τη διορατικότητά της, που φλερτάρει ανοιχτά με την προφητεία.

Λέει λοιπόν ο Κλαρκ σε ελεύθερη μετάφραση (το 1974 υπενθυμίζω): «Κάποτε οι υπολογιστές θα μας επιτρέψουν να ζούμε όπου μας αρέσει. Κάθε επιχειρηματίας ή στέλεχος θα μπορεί να ζει οπουδήποτε στον κόσμο και να κάνει τις δουλειές του μέσα από μια τέτοια συσκευή. Αυτό σημαίνει ότι δεν θα χρειάζεται να μείνουμε κολλημένοι στις πόλεις, θα μπορούμε να ζούμε στην εξοχή ή όπου αλλού θέλουμε και ακόμα να έχουμε πλήρη αλληλεπίδραση με τα άλλα ανθρώπινα όντα». Και τα είπε αυτά την εποχή που ο υπολογιστής ζύγιζε 2 τόνους, καταλάμβανε με τον όγκο του 200 τετραγωνικά και είχε τις δυνατότητες ενός smartwatch.

Kαι δεν έμεινε εκεί ο τρισμέγιστος. Όταν ρωτήθηκε από τον δημοσιογράφο αν οι μηχανές θα μας αντικαταστήσουν, απάντησε ως εξής:

«Οι υπολογιστές σίγουρα θα μας αντικαταστήσουν σε πολλές από τις διανοητικές δραστηριότητες χαμηλότερου επιπέδου και κάποια μέρα θα είναι έξυπνοι με κάθε έννοια της λέξης. Και τότε θα υπάρχουν σε αυτόν τον πλανήτη δύο ευφυή είδη κι αυτή θα είναι μια πολύ ενδιαφέρουσα κατάσταση».

Τι πιστεύετε ότι θα έλεγε σήμερα ο Κλαρκ για τα επίπεδα στα οποία έχει φτάσει η Τεχνητή Νοημοσύνη; Δικό σας! Ελάτε να συζητήσουμε μερικά σενάρια για το πώς θα φανταζόταν το παρόν μας (και το «ταχυπόδαρο» μέλλον) ένας άνθρωπος τόσο προφητικός.

VI.

ChatGPT, μάθε μου να δημιουργώ έναν πράκτορα ΤΝ (ή να παίζω κιθάρα)

Οι περισσότεροι χρησιμοποιούμε το ChatGPT, το Gemini ή το Claude σαν εξελιγμένες μηχανές αναζήτησης. Αντί να ψάχνουμε κάτι στο Google με τον παλιό καλό τρόπο, απευθυνόμαστε με ένα ερώτημα σε ένα μεγάλο γλωσσικό μοντέλο της ΤΝ και …τέλος η μπουγάδα. Οι δυνατότητες αυτών των μοντέλων όμως είναι πολύ πιο μεγάλες και δεν χάνουμε τίποτα να τις δοκιμάσουμε.

Πάρε για παράδειγμα το Tutor me του ChatGPT, που έχει δημιουργηθεί σε συνεργασία με την περίφημη Khan Academy. Το Tutor Me λοιπόν μπορεί να γίνει ο προπονητής σου σε οποιοδήποτε εγχείρημα (και θα το κάνει σοβαρά).

Του έδωσα μερικά prompts στα αγγλικά και στα ελληνικά και σας παραινώ να κάνετε και εσείς μερικές δοκιμές γιατί τα αποτελέσματα είναι εντυπωσιακά.

«Θέλω να μάθω κιθάρα σε 30 ημέρες. Παρακαλώ, ενέργησε ως ειδικός καθοδηγητής στην εκμάθηση κιθάρας. Δημιούργησε ένα αναλυτικό πλάνο εκμάθησης, που θα με βοηθήσει να αποκτήσω επάρκεια σε αυτήν την δεξιότητα.

Το πλάνο θα πρέπει να περιλαμβάνει καθημερινές εργασίες, ασκήσεις και στόχους για κάθε ημέρα, με προοδευτικά αυξανόμενο επίπεδο δυσκολίας.

Το πλάνο κάθε μέρας θα πρέπει να ολοκληρώνεται μέσα σε μία ώρα, και μέχρι το τέλος των 30 ημερών θα πρέπει να έχω ισχυρή βασική κατανόηση του παιξίματος της κιθάρας.

Παρουσίασε όλες τις πληροφορίες σε μορφή πίνακα για εύκολη κατανόηση.

Πρόσθεσε υποστηρικτικές πηγές (links, άρθρα, βίντεο, tutorials) για κάθε βήμα».

Το ίδιο έκανα και για τη δημιουργία πρακτόρων ΤΝ (AI agents). Τα αποτελέσματα με εξέπληξαν και στις δύο περιπτώσεις. Κάθε φορά που ένα λινκ ήταν «σπασμένο», δηλαδή δεν έβγαζε εκεί που μου υποσχόταν το ChatGPT, του ζητούσα να το αντικαταστήσει με ένα άλλο -και φυσικά το έκανε. Εσύ μπορείς να προσαρμόσεις τον στόχο σου για ό,τι θέλεις να μάθεις στα δικά σου μέτρα. Αλήθεια, τι θέλεις να μάθεις και ποια εργαλεία ΤΝ χρησιμοποιείς ως καθοδηγητές;

Καλημερα, δεν εχω καποιο προσωπικο παραδειγμα αλγοριθμικης προκαταληψης αλλα παρατηρω συχνα ,πολλοι απο εμας που θετουμε ερωτηματα στο ChatGPT, οτι δε δινει παντα σωστες απαντησεις η πληροφοριες ειτε αφορα καποιο τωρινο γεγονος ειτε παρελθοντικο. Με συνεπεια να μην εμπιστευομαστε η και ν'απομακρυνομαστε απο την Al λογω δυσαρεσκειας. Δε ξερω αν ειναι θεμα δεδομενων προγραμματιστη η τι ακριβως σημαινει αυτο αλλα ειναι τελειως οξυμωρο να βλεπεις οτι γινονται αλματα στον κλαδο της ιατρικης (οπως η πρωτη εξωσωματικη τεκνοποιηση που εγινε πριν λιγους μηνες με τη χρηση της Al) και να μη μπορεις να παρεις μια σωστη απαντηση/πληροφορηση σε ιστορικα γεγονοτα κ.ο.κ. Καθε substack εχει και μια καινουργια πληροφορια , γνωση και προβληματισμο, ευχαριστω θερμα!